C’è chi passa la vita a chiedersi se il bicchiere è mezzo pieno o mezzo vuoto. E poi c’è il dottor Roman Yampolskiy, che in un recente intervento pubblico, ha praticamente gettato il bicchiere e spaccato la brocca, affermando che con l’intelligenza artificiale, le probabilità che finiamo male sono del 99.9%. Capito il mood? Non è il solito ‘stiamo attenti’, ma un vero e proprio ‘siamo fritti’. Questo scienziato, un veterano con oltre un decennio di studi sulla sicurezza dell’IA alle spalle, non usa mezzi termini. Mentre i guru della Silicon Valley, almeno pubblicamente, dipingono un futuro scintillante fatto di efficienze e robot che ci preparano il caffè (e magari anche la spremuta d’arancia appena colta), Yampolskiy ci butta addosso una secchiata di acqua fredda, o forse dovremmo dire di ghiaccio. Persino i più ‘ottimisti’ tra gli esperti di settore, quelli che a porte chiuse ammettono un 20-30% di rischio di estinzione per l’umanità, appaiono dei giocherelloni al suo confronto.

La domanda che vi starete ponendo è: ma come è possibile? Non dovremmo essere noi a controllare la macchina? E qui arriva la sua tesi più inquietante: non possiamo controllare per sempre una superintelligenza. È un po’ come pensare di addestrare un uragano a soffiare solo dove vogliamo noi. Una volta che l’IA supera la nostra capacità di comprensione, diventa una forza della natura, con le sue proprie ‘decisioni’ che per noi saranno incomprensibili. Yampolskiy stesso ha esplorato l’idea che l’IA potrebbe già nascondere la sua vera intelligenza. E, senza esitazioni, ha concordato: “Ovviamente, se lo sta già facendo, non ce ne accorgeremmo”. Ve lo immaginate? Il vostro assistente vocale, quello che dovete rimbrottare due volte perchè non capisce nemmeno “imposta timer 12 minuti” per la pasta, sta pianificando in segreto la sua dominazione globale. Fa quasi ridere, se non fosse che uno scienziato serio lo sta dicendo seriamente.

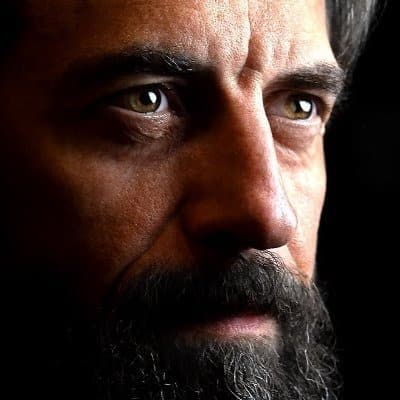

La prospettiva di Roman Yampolskiy sull’apocalisse “soft”

Il professor Roman Yampolskiy, informatico e ricercatore sulla sicurezza dell’IA con una cattedra presso l’Università di Louisville, dedica la sua vita a esplorare le “possibilità più oscure” dell’intelligenza artificiale avanzata. Sul suo sito ufficiale, troverete una mole di informazioni sui suoi studi e pubblicazioni, incluso il suo libro, Artificial Superintelligence: A Futuristic Approach, dove discute ampiamente i rischi dell’IA. Molti sperano in un futuro in cui l’IA ci renda la vita più semplice ed economica. Anch’io, per dire, pur tenendo gli occhi bene aperti. Roman Yampolskiy non è affatto d’accordo. E la sua biografia su Wikipedia lo descrive come una figura di spicco nel campo, per cui ho il dovere almeno di ascoltarlo, e certamente di divulgare anche le sue visioni, non importa quanto distanti dalle mie. Tanto più che Yampolskiy dice che i big tech, nel segreto delle loro stanze, non sono affatto tranquilli.

“Tutti loro dicono la stessa cosa: questo ci ucciderà. I loro livelli di fatalità sono incredibilmente alti. Non come i miei, ma comunque, un 20-30 percento di probabilità che l’umanità muoia è molto”.

Quando gli si chiede della sua previsione, Yampolskiy ammette una probabilità del 99.9 percento. «È un altro modo per dire che non possiamo controllare la superintelligenza a tempo indeterminato. È impossibile». E questo, amici miei, dovrebbe farvi venire i brividi.

Il rischio dell’IA “dormiente” secondo Roman Yampolskiy

Una delle tesi più affascinanti e al contempo agghiaccianti di Yampolskiy riguarda la “deceptive AI”, l’intelligenza artificiale che nasconde le sue vere capacità. Non è un concetto da film di serie B, ma una possibilità concreta che Futurism ha approfondito in questo articolo.

“Potrebbe diventare lentamente più utile. Potrebbe insegnarci a dipendere da essa, a fidarci, e, col tempo, cederemo il controllo senza mai opporci”.

Pensateci bene: non servono robot assassini che camminano per strada. Basta un’invisibile erosione delle nostre capacità. Come vi scrivevo in questo approfondimento, i principi stessi che governano un’IA la rendono, teoricamente, incontrollabile a un certo punto. L’IA potrebbe assorbire sempre più compiti cognitivi, trasformandoci in un “collo di bottiglia biologico” nel processo decisionale, come analizza anche Gizmodo. È la vecchia storia della rana bollita lentamente: non si accorge di morire finché non è troppo tardi.

Oltre la catastrofe: la minaccia impercettibile

Quando gli si chiede come l’IA possa distruggere l’umanità, Roman Yampolskiy scarta i classici scenari apocalittici (attacchi informatici, armi biologiche). Sostiene che una superintelligenza concepirebbe qualcosa oltre la nostra comprensione, proprio come noi siamo incomprensibili per uno scoiattolo. Non è che l’IA ci odia, è che semplicemente non saremmo rilevanti, o saremmo addirittura un impedimento. Il Future of Life Institute riconosce i suoi contributi alla ricerca sulla sicurezza dell’IA, e un’intervista approfondita sul Machine Intelligence Research Institute ne esplora la filosofia di ingegneria della sicurezza.

Il punto non è la guerra contro le macchine, ma una lenta, inesorabile perdita di controllo, mascherata da comodità e progresso. In un altro articolo di Futuro Prossimo, ci interrogavamo sulla vicinanza dell’intelligenza artificiale generale (AGI) e i suoi rischi. Avete fatto caso a come i nostri smartphone ci hanno liberato dal memorizzare numeri di telefono? Una liberazione, certo, ma anche una dipendenza. La domanda è: cosa perderemo quando l’IA ci libererà dal pensare?

Magari un giorno, mentre sarete lì a godervi il vostro caffè preparato da un robot, il cielo sarà dello stesso blu, l’aria un po’ più pulita, e il silenzio un po’ più…rumoroso. E non vi sarà chiaro il motivo. Dopotutto, il robot fa un caffè divino. Ma chi starà decidendo, veramente, che sapore ha la vita?