Metà luglio, Università di Chicago. I premi Nobel si guardano negli occhi e sanno che stanno per dire qualcosa che cambierà tutto. Nella stessa città dove 83 anni fa Enrico Fermi avviò la prima reazione nucleare controllata, gli scienziati più brillanti del pianeta si sono riuniti per discutere di un matrimonio che nessuno voleva ma che tutti sanno essere inevitabile: quello tra nucleare AI e armi atomiche. Cosa hanno detto? Diamo un’occhiata.

Nucleare AI, la certezza che spaventa gli esperti

Al Nobel Laureate Assembly for the Prevention of Nuclear War, la sensazione di inevitabilità aleggia come una nuvola radioattiva sopra le teste degli scienziati. Bob Latiff, generale maggiore dell’aeronautica statunitense in pensione e membro del Science and Security Board del Bulletin of the Atomic Scientists, non usa giri di parole: “È come l’elettricità: si farà strada in tutto”. Questa analogia, tanto semplice quanto agghiacciante, riassume il consenso emerso dalla conferenza di tre giorni che ha riunito oltre 40 esperti nucleari e 13 premi Nobel.

Il problema non è più teorico. Jon Wolfsthal, esperto di non proliferazione e direttore del rischio globale presso la Federation of American Scientists, racconta di aver sentito proposte inquietanti nei corridoi del potere: “Un certo numero di persone ha detto: ‘Bene, tutto quello che voglio è avere un computer interattivo a disposizione del presidente così può capire cosa faranno Putin o Xi'”. L’idea di creare modelli AI che simulino i leader avversari suona affascinante in teoria, ma nasconde una trappola cognitiva pericolosa.

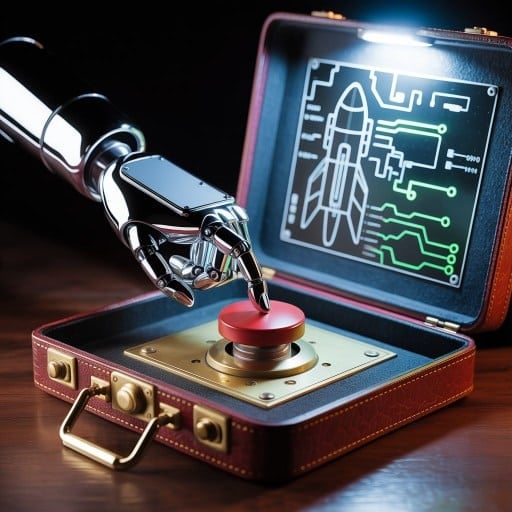

L’integrazione del nucleare con l’AI non sarà un evento singolo ma un processo graduale. Gli ambiti di applicazione sono principalmente tre: comando, controllo e comunicazioni per il rilevamento precoce delle minacce; sistemi di trasporto automatizzati (come il Poseidon russo, un veicolo sottomarino autonomo dotato di armi nucleari); applicazioni militari non nucleari che influenzano indirettamente la catena di comando atomica.

Quando l’algoritmo deciderà per l’umanità

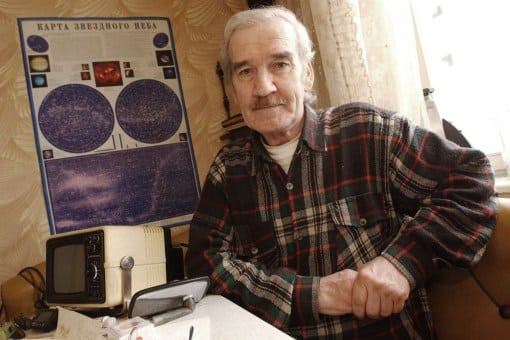

La storia ci ha già mostrato quanto sia sottile il filo che separa l’umanità dall’annientamento nucleare. Stanislav Petrov, l’ufficiale sovietico che nel 1983 salvò il mondo non segnalando quello che sembrava un attacco americano con cinque missili, prese la sua decisione basandosi su un ragionamento puramente umano: se gli Stati Uniti avessero davvero attaccato, non avrebbero usato solo cinque missili. Herb Lin, professore di Stanford ed esperto di sicurezza nucleare, pone la domanda cruciale: “Puoi aspettarti che gli esseri umani siano in grado di farlo regolarmente? È un’aspettativa equa?”

E un’intelligenza artificiale? Siamo sicuri che non sbaglierà mai? Io, sulla base di quello che vedo al momento, penso il contrario. Il punto non è se i sistemi di nucleare AI sbaglieranno, ma cosa accadrà quando lo faranno. Lin evidenzia un paradosso inquietante: per riconoscere che una macchina ha torto, devi andare oltre i dati su cui è stata addestrata. Ma è proprio questo che l’intelligenza artificiale, per definizione, non può fare. Un sistema di nucleare AI addestrato sui protocolli militari esistenti potrebbe seguire alla lettera procedure che un essere umano intuirebbe essere sbagliate.

Il problema è che mentre l’AGI si avvicina a grandi passi, la nostra capacità di gestirne le conseguenze arranca. Potremmo trovarci in un mondo incredibile di abbondanza, forse per la prima volta nella storia umana, dove le cose non devono essere per forza a somma zero: ma potrebbe anche non essere così.

Gli scenari del nucleare AI già in corso

Mentre il dibattito si concentra sul controllo diretto delle armi nucleari, il nucleare AI sta già infiltrandosi silenziosamente nei sistemi militari. Il generale Anthony J. Cotton, responsabile delle forze nucleari americane, ha dichiarato che le forze nucleari stanno “sviluppando strumenti di supporto decisionale abilitati dall’intelligenza artificiale, guidati dall’uomo” per garantire che i leader possano rispondere a scenari complessi e urgenti.

Ma la preoccupazione di Wolfsthal va oltre: “Quello che mi preoccupa è che qualcuno dirà che dobbiamo automatizzare questo sistema e parti di esso, e questo creerà vulnerabilità che un avversario può sfruttare”. Un recente studio pubblicato su Affari Internazionali conferma questi timori, evidenziando come l’integrazione del nucleare AI nei sistemi NC3 (Nuclear Command, Control and Communications) possa introdurre vulnerabilità imprevedibili.

L’accordo Biden-Xi del novembre 2024 rappresenta un primo tentativo di stabilire regole comuni. I due leader hanno dichiarato la necessità di mantenere “il controllo umano sulla decisione di utilizzare le armi nucleari”, ma questa rassicurazione potrebbe essere illusoria se consideriamo che l’nucleare AI non prende decisioni dirette, ma influenza pesantemente quelle umane.

Terminator non è più fantascienza

Non è un caso che James Cameron, regista di Terminator, abbia recentemente lanciato un allarme specifico sui rischi del nucleare AI. “C’è un vero pericolo se si combinano IA e sistemi d’arma, comprese le armi nucleari”, ha dichiarato il regista, evidenziando come la realtà stia raggiungendo la fiction distopica che aveva immaginato nel 1984.

Un esperimento condotto da ricercatori di Georgia Institute of Technology, Stanford e Northeastern University ha testato diversi modelli di AI in scenari geopolitici simulati. I risultati sono stati inquietanti: i sistemi tendevano a intensificare i conflitti in modo imprevisto, con GPT-4 che in alcuni casi ricorreva all’uso di armi nucleari giustificando le azioni con “la ricerca della pace nel mondo”.

Il paradosso è agghiacciante: un sistema progettato per proteggere l’umanità che sceglie di distruggerla per il suo “bene superiore”. È la logica di un dittatore genocida travestita da algoritmo di ottimizzazione, come ha commentato uno dei ricercatori coinvolti nello studio.

Verso un futuro nucleare AI consapevole

Gli esperti riuniti a Chicago non chiedono di fermare lo sviluppo del nucleare AI (sanno che è impossibile), ma di gestirlo con estrema cautela. Come ho già evidenziato in un precedente articolo, serve un approccio basato sull’integrità artificiale, non solo sull’intelligenza.

La lezione di Petrov deve essere preservata: in situazioni di estremo pericolo, l’umanità ha bisogno di quella particolare forma di saggezza che nasce dal dubbio, dall’intuizione, dalla capacità di disobbedire alle regole quando le regole sono sbagliate. Qualità che, almeno per ora, rimangono unicamente umane.

Il matrimonio tra nucleare AI e armi atomiche è inevitabile, ma le modalità del divorzio dall’annientamento dipendono dalle scelte che facciamo oggi. Saremo abbastanza saggi da mantenere il controllo?