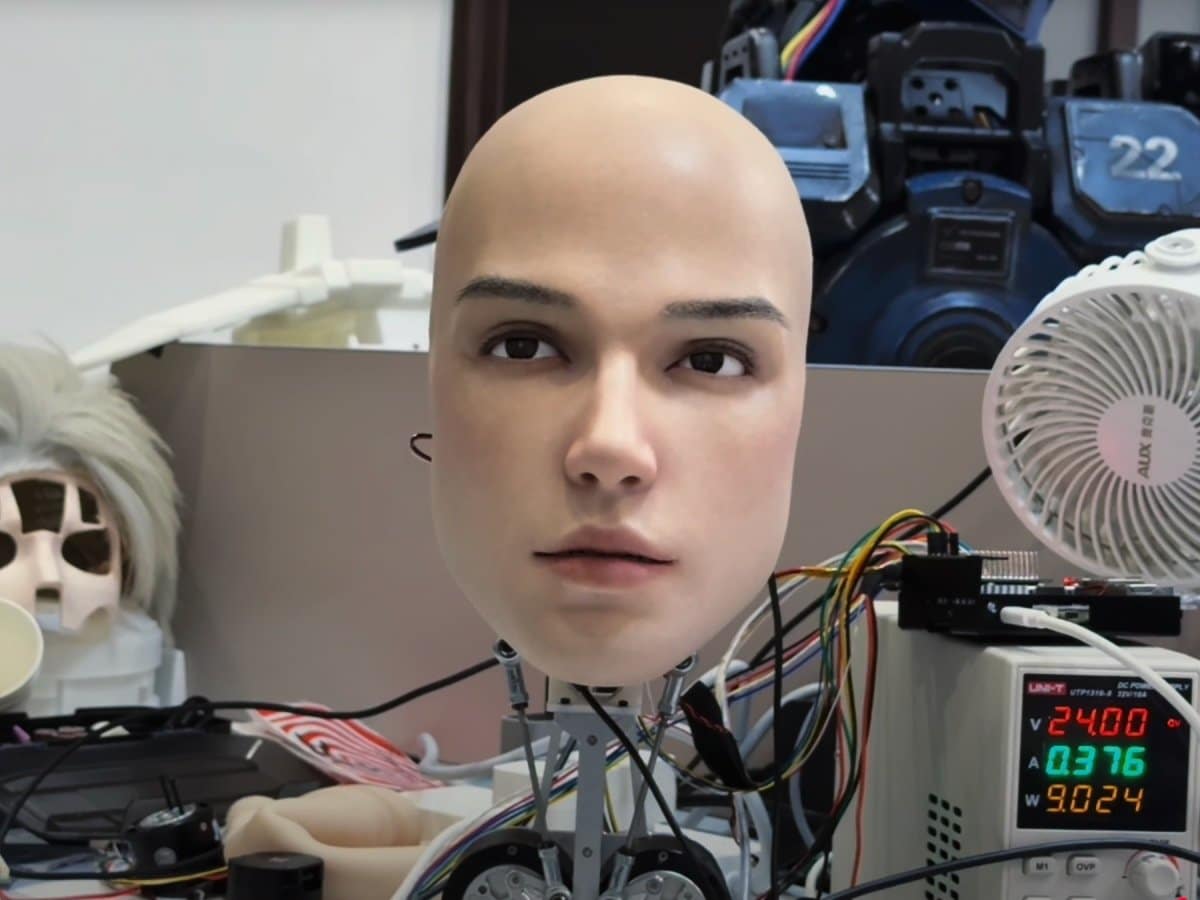

La testa si gira. Lenta, come se stesse cercando di capire dove si trova. Le palpebre si chiudono, si riaprono. Un battito. Poi un altro. Gli occhi (telecamere, in realtà) seguono qualcosa fuori campo. L’espressione è quasi interrogativa, tipo “cosa sto guardando?”. Sembra viva. Ma non lo è. È Origin M1, l’ultima creazione di AheadForm, una startup cinese che ha deciso di rendere i robot umanoidi meno rigidi e più… umani. Il video della faccia robot pubblicato su YouTube è diventato virale in poche ore. La gente lo guarda, poi lo riguarda. Alcuni lo trovano affascinante. Altri inquietante. Quasi tutti concordano su una cosa: da oggi siamo un po’ più vicini a Westworld.

Venticinque motori per una faccia che convince

Lo dico subito: Origin M1 non è un giocattolo. È un sistema progettato per la ricerca sull’interazione uomo-robot, con applicazioni potenziali nel customer service, nell’educazione e nella sanità. La testa integra 25 motori brushless, dispositivi minuscoli che lavorano in silenzio per creare i movimenti sottili che rendono credibile la faccia robot: lo sguardo che si sposta, le palpebre che battono, quel piccolo cenno del capo che sembra quasi pensieroso.

Nelle pupille sono integrate telecamere RGB che permettono al robot di “vedere” l’ambiente. Microfoni e altoparlanti consentono l’interazione vocale in tempo reale. L’obiettivo di AheadForm, fondata nel 2024 a Hangzhou, è chiaro: creare robot capaci di esprimere emozioni, percepire l’ambiente e interagire con gli esseri umani in modo naturale. Un po’ come un collega educato ma silenzioso: osserva, ascolta, risponde.

Il precedente: Emo e la scienza delle espressioni della faccia robot

Il fondatore di AheadForm, Yuhang Hu, ha già fatto parlare di sé. Nel 2024 ha pubblicato uno studio su Science Robotics che descrive Emo, un robot facciale sviluppato alla Columbia University. Emo può prevedere un sorriso umano 839 millisecondi prima che accada, analizzando i cambiamenti sottili nel volto della persona di fronte. Poi sorride a sua volta, simultaneamente. Non è mimesi ritardata. È coespressione.

La ricerca dimostra che i robot capaci di anticipare le emozioni umane creano interazioni più fluide e genuine. La sensazione di essere compresi, anche da una macchina, migliora la qualità dell’esperienza. Finché non ti chiedi: ma serve davvero che mi sorrida?

La valle non è più così profonda

AheadForm ha sviluppato diverse linee di robot. C’è la serie Elf, con orecchie a punta e sistemi di controllo precisi. C’è la Lan Series, più simile agli umani e progettata per essere economica. E c’è Xuan, un modello a corpo intero con testa interattiva e capacità espressive avanzate.

L’azienda punta a integrare sistemi di intelligenza artificiale come i large language models direttamente nelle teste robotiche. Il risultato sarebbe un robot che non solo capisce cosa dici, ma anche come lo dici. E risponde di conseguenza, con il tono giusto, l’espressione adeguata, la tempistica corretta.

Origin M1 non è ancora disponibile commercialmente. Ma il video circola, le reazioni si moltiplicano, e la domanda resta sospesa: quando un robot ti guarda negli occhi e sbatte le palpebre, cosa cambia nel modo in cui lo percepisci? Forse nulla. O forse tutto. Dipende da quanto siamo pronti ad accettare che una macchina possa sembrare “presente”.

Intanto AheadForm continua a perfezionare il sistema. E noi continuiamo a guardare quei video, cercando di capire se ciò che proviamo è curiosità o disagio. Probabilmente entrambi.