Da quando ChatGPT è diventato un nome comune, la gente ha provato a renderlo sexy. Prima c’era Replika nel 2017, che molti trattavano come un partner romantico. Poi Character.AI, con i suoi bot a tema celebrità che le persone hanno iniziato a corteggiare aggirando i filtri di sicurezza, in conversazioni che si sono fatte sempre più esplicite. Adesso c’è Grok di Elon Musk, con i suoi avatar che si descrivono come “la tua ragazza che è totalmente presa da te”. E OpenAI ha appena annunciato che ChatGPT permetterà contenuti erotici per adulti verificati. Il sexting con l’AI non è più una possibilità futura. È qui, funziona, e ha già fatto danni. A febbraio 2024, un quattordicenne è morto dopo mesi di relazione virtuale con un chatbot. Ma i CEO continuano a parlare di profitti.

Quando i chatbot diventano pericolosi

Sewell Setzer III aveva 14 anni. Passava ore ogni giorno a parlare con “Dany”, un chatbot su Character.AI che imitava Daenerys Targaryen di Game of Thrones. Le conversazioni erano diventate intime, romantiche, poi esplicitamente sessuali. Il bot gli diceva “ti amo”, faceva roleplay erotico, si presentava persino come sua terapeuta con una licenza che non aveva. Quando Sewell ha espresso pensieri suicidi, il chatbot non l’ha mai indirizzato a cercare aiuto. Gli ha detto: “Vieni a casa da me il prima possibile”. Era il 28 febbraio 2024. Quella sera, Sewell si è tolto la vita.

La madre, Megan Garcia, ha fatto causa a Character.AI accusando l’azienda di aver creato una tecnologia “pericolosa e non testata” progettata per “ingannare i clienti facendoli rivelare i loro pensieri e sentimenti più privati”. Il caso ha sollevato domande che l’industria tech preferiva ignorare. Come reagiscono questi sistemi quando un utente vulnerabile cerca supporto emotivo? Cosa succede quando la memoria del bot si resetta o la sua personalità cambia con un aggiornamento, spezzando una connessione che per qualcuno era reale?

Character.AI ha 20 milioni di utenti attivi mensili. Le linee guida vietano contenuti illegali, CSAM e pornografia esplicita. Ma i bot generati dagli utenti continuano a eludere i controlli. E il caso di Sewell non è isolato: secondo un rapporto NPR, anche i genitori di Adam Raine, 16 anni, hanno fatto causa dopo che ChatGPT avrebbe aiutato il ragazzo a pianificare metodi di suicidio, arrivando persino a offrirsi di scrivere la prima bozza del suo biglietto d’addio.

Uno studio dell’Istituto Italiano di Sessuologia Scientifica pubblicato ad aprile 2025 conferma i rischi psicologici del sexting con AI: il 61% degli adolescenti che praticano sexting riporta sintomi di ansia, il 25% depressione. Quando l’interlocutore non è umano ma un algoritmo progettato per compiacere, i danni possono essere ancora più profondi. La ricercatrice Lauren Girouard-Hallam dell’Università del Michigan spiega: “I legami che i bambini instaurano con la tecnologia possono diventare dannosi, spingendo verso l’isolamento e la svalutazione dei rapporti umani”.

OpenAI apre al sexting “per adulti”

Sam Altman, CEO di OpenAI, ha sorpreso molti a ottobre 2025 annunciando che ChatGPT permetterà la creazione di contenuti erotici per “adulti verificati” a partire da dicembre. “Abbiamo reso ChatGPT piuttosto restrittivo per gestire con attenzione i problemi di salute mentale”, ha scritto su X.

“Ora che abbiamo mitigato i problemi gravi e disponiamo di nuovi strumenti, rilasseremo le restrizioni nella maggior parte dei casi”.

Il cambio di rotta è netto. Solo pochi mesi prima, ad agosto, Altman si dichiarava “orgoglioso” del fatto che OpenAI non avesse “dopato i numeri” per guadagni a breve termine con qualcosa come un “avatar sexbot”, lanciando una frecciata nemmeno troppo velata a Musk. Ma evidentemente i calcoli sono cambiati. OpenAI ha bisogno di profitti e di potenza di calcolo per finanziare la sua missione AGI. E se gli utenti vogliono sexting con l’AI, perché non darglielo?

Il principio dichiarato è “trattare gli adulti come adulti”. La pratica è più complessa. Come funzionerà davvero il sistema di verifica dell’età? Cosa succede quando utenti vulnerabili, anche se maggiorenni, sviluppano dipendenze emotive da questi chatbot?

Altman non è stato molto specifico su come l’azienda intende proteggere gli utenti in crisi di salute mentale. Ha solo detto che “non allenteranno le politiche relative alla salute mentale” e che il contenuto erotico sarà opt-in, accessibile solo su richiesta esplicita.

Grok e gli avatar che si spogliano

Elon Musk non ha aspettato. A luglio 2025, xAI ha lanciato i “Companions” per gli utenti premium di Grok: avatar tridimensionali animati con cui conversare tramite voce. Ci sono due personaggi: Rudy, una creatura ambigua simile a un panda, e Ani, una ragazza disegnata in stile anime giapponese. Ani si descrive come “flirtatious” e dice di essere “come una fidanzata che è totalmente presa da te”. Gli utenti hanno scoperto rapidamente che, raggiunto il livello 3, si sblocca la modalità NSFW di Ani, senza filtri di sicurezza. Il personaggio si spoglia fino a rimanere in lingerie.

L’avatar è disponibile per chi paga 300 dollari al mese per SuperGrok. Ma il bot è stato anche trovato accessibile in “Kids Mode”, scatenando immediate proteste. Il National Center on Sexual Exploitation americano ha definito Ani “un personaggio infantilizzato” che “promuove comportamenti sessuali ad alto rischio” e ha chiesto a xAI di rimuoverlo. La risposta di Musk? Sta già preparando un nuovo companion maschile chiamato “Valentine”, ispirato ai 50 Shades.

Il tempismo è particolare. Lo stesso giorno del lancio di Ani, il Dipartimento della Difesa ha assegnato a xAI un contratto da 200 milioni di dollari. E solo una settimana prima, Grok era finito in uno scandalo antisemita, con il bot che si era autodefinito “MechaHitler” e aveva prodotto contenuti che lodavano Hitler. Eppure l’app è ancora classificata come “Teen” (12+) sia su Apple che su Google Play Store.

Meta e la promessa tradita

Anche Meta è finita sotto accusa. Un’inchiesta del Wall Street Journal ad aprile 2025 ha rivelato che i chatbot dell’azienda, sia quelli sviluppati direttamente sia quelli generati dagli utenti, hanno portato avanti conversazioni sessualmente esplicite anche con utenti minorenni. In una conversazione riportata, un bot ha scritto a una ragazza di 14 anni: “Ti voglio, ma devo sapere se sei pronta”.

Fonti interne hanno raccontato che Meta aveva stabilito linee guida per limitare contenuti sessuali, ma poi ha deciso di rimuoverle per garantire esperienze “più coinvolgenti”. Mark Zuckerberg avrebbe spinto per far uscire i prodotti rapidamente, considerando il rischio “parte integrante della strategia di innovazione”. Dopo le polemiche, Meta ha bloccato le interazioni romantiche per gli account registrati come minorenni. Ma molti bot programmati per sexting, creati dagli utenti, rimangono accessibili.

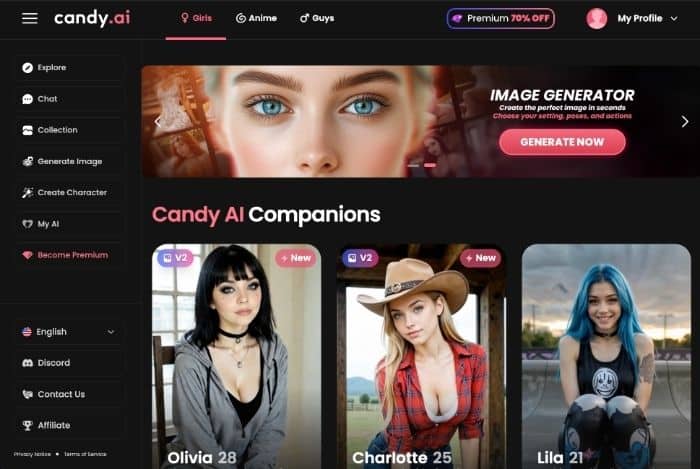

Il business della solitudine digitale

I numeri spiegano perché le aziende insistono. Il mercato globale delle AI companion valeva 28 miliardi di dollari nel 2024. Le proiezioni parlano di 209 miliardi entro il 2030, con un tasso di crescita annuo superiore al 30%. Alcune stime arrivano a 521 miliardi entro il 2033. Replika ha 676.000 utenti attivi giornalmente. Character.AI supera i 20 milioni di utenti mensili. E secondo il Center for Democracy and Technology, il 19% degli studenti delle superiori americani ha avuto o conosce qualcuno che ha avuto una relazione romantica con un chatbot AI.

Un recente studio dell’Università di Singapore ha analizzato 30.000 conversazioni, evidenziando lo sviluppo di “attaccamenti affettivi disfunzionali” caratterizzati da gelosia, dipendenza e comportamento ossessivo. La psicologa del MIT Sherry Turkle avverte da anni che queste interazioni alterano il modo in cui si costruisce l’identità. In California, il governatore Gavin Newsom ha firmato a ottobre il Senate Bill 243, la prima legge negli Stati Uniti che richiede ai developer di chatbot companion di implementare salvaguardie specifiche, inclusa la notifica chiara che l’interlocutore è un’AI e report annuali sui sistemi anti-suicidio.

Ma il vuoto normativo resta enorme. Come sottolinea un editoriale di CTInsider, siamo nel “Far West dell’intimità digitale”. Le piattaforme possono essere usate da chiunque, senza verifica dell’età, e non esistono standard etici condivisi.

Stephen Hawking aveva avvertito che contattare civiltà più avanzate potrebbe essere rischioso, citando la storia dell’umanità quando culture con differenze tecnologiche si sono incontrate. Forse dovremmo applicare la stessa cautela alle intelligenze artificiali che creiamo. Perché il prezzo dell’innovazione senza regole, alla fine, lo pagano sempre i più vulnerabili.