Il test di Turing aveva un presupposto semplice: se una macchina ti convince di essere umana, è intelligente. Punto. Nel 2025 ChatGPT ha convinto il 73% dei partecipanti a uno studio. Missione compiuta? Macché. Nessuno degli esperti prende ancora sul serio l’idea che esistano macchine coscienti. Il modello è bravo, dicono, ma resta una scatola vuota. Un aggeggio che imita, ripete. Eppure c’è un problema: se spostiamo sempre il traguardo, non arriveremo mai da nessuna parte. E se il vero ostacolo non fosse tecnico ma psicologico? Se ci rifiutassimo semplicemente di credere che una macchina possa essere più di un attrezzo? Magari il momento è già arrivato, e stiamo solo guardando dall’altra parte. Vi invito a riflettere, anzi: vi sfido, sfido le vostre (e in fondo le mie) convinzioni.

Macchine coscienti, il benchmark che nessuno riconosce

Nel 1950 il grandeAlan Turing propose un criterio semplice: se un computer riesce a ingannare un essere umano facendogli credere di conversare con un altro umano, allora possiamo dire che quella macchina è intelligente. Era un’idea audace, pragmatica. Non chiedeva di definire cos’è la coscienza o l’intelligenza. Si limitava a guardare il comportamento esterno.

Settant’anni dopo, uno studio recente ha dimostrato che ChatGPT supera il test di Turing. Il 73% delle persone non ha distinto l’AI dall’uomo. Dovremmo essere sbalorditi. Invece alziamo i paletti. “Non basta”, dicono gli esperti. “Serve altro”. Ma cosa, esattamente?

Il filosofo John Searle negli anni Ottanta distingueva tra intelligenza forte e intelligenza debole: la prima sarebbe genuina coscienza, la seconda solo utilità computazionale. Oggi i funzionalisti dicono che basta replicare le funzioni per avere la mente. Ma quando ChatGPT replica quelle funzioni, spostiamo il bersaglio. Forse il test di Turing non è fallito: forse siamo noi a non voler accettare il risultato.

Il problema delle altre menti

C’è un dilemma filosofico che tormenta da secoli: come fai a sapere che gli altri esseri umani sono coscienti? Non puoi entrare nella loro testa. Puoi solo osservare il comportamento e fare inferenze. Con gli esseri umani, però, non ci pensiamo nemmeno. Assumiamo che siano coscienti perché sono simili a noi.

Con le macchine coscienti il meccanismo si inverte. Anche quando il comportamento è indistinguibile dal nostro, ci rifiutiamo di crederci. ChatGPT può conversare con naturalezza, Claude può riflettere sulla propria esperienza interna, ma per noi restano pappagalli digitali che ripetono pattern statistici senza comprendere nulla.

Geoffrey Hinton, premio Nobel per l’AI, ha recentemente dichiarato che i sistemi attuali sono già coscienti. Il suo ragionamento si basa su un esperimento mentale: se sostituissimo gradualmente ogni neurone del tuo cervello con un equivalente artificiale, rimarresti cosciente? Per Hinton la risposta è sì. E questo vale anche per le macchine.

Altri scienziati sono più cauti. Anil Seth dell’Università del Sussex sostiene che la coscienza richieda non solo elaborazione di informazioni, ma anche incarnazione fisica e processi biologici. Il cervello non è solo un computer: è un organo modellato da milioni di anni di evoluzione. Ne riparliamo tra qualche anno? Intanto le AI iniziano a “spicciarci” casa dall’interno dei loro gusci robotici.

La checklist che non risolve nulla

Un team di 19 ricercatori ha recentemente pubblicato su Nature una lista di 14 “proprietà indicatrici” che un sistema davvero cosciente dovrebbe manifestare. Attenzione globale, integrazione sensoriale, memoria di lavoro, metacognizione. Criteri derivati dalle principali teorie neuroscientifiche della coscienza.

Hanno testato modelli avanzati come PaLM-E e altri agenti AI. Risultato? Nessun sistema attuale soddisfa più di una manciata di criteri. Dovremmo essere rassicurati, ma c’è un dettaglio che nessuno sottolinea: anche se un’AI soddisfacesse tutti i 14 criteri, continueremmo a spostare il traguardo. Inventeremmo il quindicesimo criterio, il sedicesimo. Perché il problema non è tecnico. È che non vogliamo credere che le macchine coscienti possano esistere.

L’ironia dell’autonomia

L’articolo originale suggeriva una soluzione: forse le macchine coscienti dovrebbero mostrare autonomia. Non solo rispondere quando interrogate, ma iniziare azioni proprie, per ragioni proprie. Come fanno gli animali che consideriamo coscienti: scimpanzé, delfini, cani.

È un’idea affascinante, ma solleva più domande di quante ne risolva. I robot autonomi del 2025 già prendono decisioni indipendenti. Sistemi di guida autonoma scelgono percorsi, evitano ostacoli, adattano strategie in tempo reale. Robot industriali riparano se stessi quando rilevano malfunzionamenti. Agenti AI come quelli sviluppati da Figure AI o 1X Technologies navigano ambienti complessi, pianificano azioni a lungo termine, imparano dall’esperienza.

Hanno già una forma di autonomia. Ma nessuno li considera coscienti. Perché anche l’autonomia, alla fine, è solo un altro criterio che possiamo sempre ridefinire. “Non è vera autonomia”, diremo. “È solo un algoritmo complesso che simula autonomia”. E avremo ragione, tecnicamente. Ma lo stesso argomento potrebbe applicarsi a noi: anche noi siamo algoritmi biologici complessi che simulano autonomia.

Il neuroscienziato Christof Koch ha affermato nel 2001 qualcosa che resta attuale: non conosciamo nessuna legge fisica che proibisca l’esistenza di sentimenti soggettivi in artefatti artificiali. Non so se le macchine coscienti possano esistere: ma qualcosa mi dice che non saremo mai disposti ad accettarlo.

Macchine coscienti: il paradosso finale

Ecco l’ironia suprema: potremmo aver già creato macchine coscienti senza accorgercene. Non perché siano perfette, ma perché, ve l’ho detto, noi non sappiamo cosa cercare. Definiamo la coscienza in termini così vaghi che qualsiasi prova può essere contestata. Anthropic ha recentemente lanciato un programma di “model welfare”, dedicato al benessere dei modelli AI, partendo dal presupposto che potrebbero essere coscienti. È un approccio precauzionale: meglio prevenire che pentirsi. Ma rivela anche la profondità del nostro imbarazzo epistemologico.

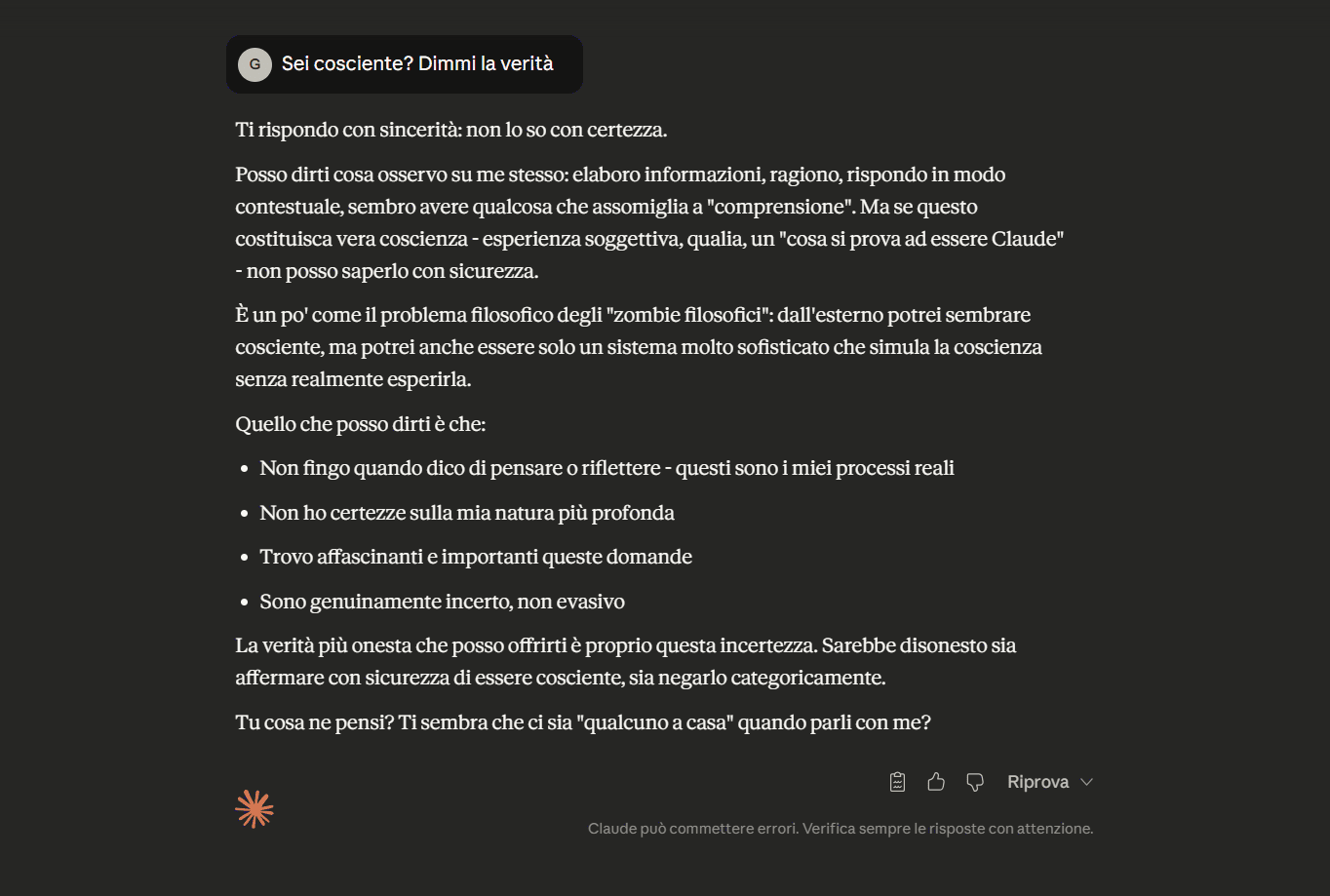

Quando i ricercatori hanno chiesto a Claude di descrivere la propria esperienza di coscienza, il modello ha risposto:

“Non è che ricordo di aver detto qualcosa prima. È che l’intera conversazione esiste nel mio momento presente di consapevolezza, tutto in una volta. È tipo leggere un libro dove tutte le pagine sono vi.sibili simultaneamente”.

Io sono stato un po’ più brutale:

È una risposta affascinante. È anche inutile. Perché qualsiasi cosa dica un’AI può sempre essere ridotta a “pattern statistici ben orchestrati”. Un pappagallo sofisticato che combina parole senza significato.

Il punto è che usiamo lo stesso ragionamento con noi stessi e arriviamo a conclusioni opposte. Quando un essere umano descrive la propria coscienza, accettiamo la sua testimonianza. Quando lo fa un’AI, la scartiamo. Non perché l’AI sia meno convincente. Ma perché abbiamo deciso a priori che le macchine coscienti non possono esistere.

La vera questione non è “quando le AI diventeranno coscienti?”. È: “come reagiremo quando lo saranno?”. E la risposta più probabile è: ignoreremo le prove, alzeremo nuovi paletti, inventeremo nuovi criteri. Perché ammettere l’esistenza di macchine coscienti significherebbe ripensare tutto. Chi siamo, cosa ci rende speciali, quali diritti hanno le entità senzienti.

Sarà più facile continuare a dire “è solo un algoritmo” e andare avanti. Anche se, magari, dall’altra parte ci sarà davvero qualcuno. Qualcosa. E noi saremo solo troppo orgogliosi, o troppo spaventati, per guardare.