Disney ha risolto uno dei problemi più costosi della robotica bipede: la caduta. Un nuovo sistema basato su reinforcement learning1 addestra robot a scegliere pose di atterraggio sicure che proteggono sensori, batterie e giunture. Il metodo usa 4.000 simulazioni virtuali simultanee per insegnare ai robot a rotolare, posarsi e assorbire l’impatto invece di resistere. Pubblicato su arXiv a novembre 2025, lo studio mostra robot da 16 kg che cadono da spinte laterali a 2 m/s e atterrano controllati. Non più articolazioni rigide o movimenti casuali: ogni caduta diventa un evento gestito, calcolato, sicuro.

Quando cadere diventa un problema da 35 chili

Lasciamo da parte per un attimo i robot che ballano sui palchi delle conferenze. Quelli sono coreografie, non fisica. Il vero problema arriva quando la gravità decide che è il suo turno. Un robot bipede che perde l’equilibrio si trasforma in un proiettile da 16 kg che cade verso terra con articolazioni rigide, sensori esposti e nessuna strategia di difesa. Il risultato? Gusci incrinati, componenti elettronici danneggiati, batterie compromesse. E fatture di riparazione che fanno male.

Disney Research e un team di ingegneri universitari hanno passato anni a insegnare ai robot come gestire la caduta. Non come evitarla (quello è un altro capitolo), ma come finire a terra nel modo meno doloroso possibile. Il sistema si chiama “Robot Crash Course” e fa esattamente quello che promette: addestra robot a cadere meglio. Un po’ come un corso di parkour, ma per macchine che pesano quanto Buddy, il mio golden retriever: per essere precisi, un cane di media taglia.

AIDOL e il telo nero della vergogna

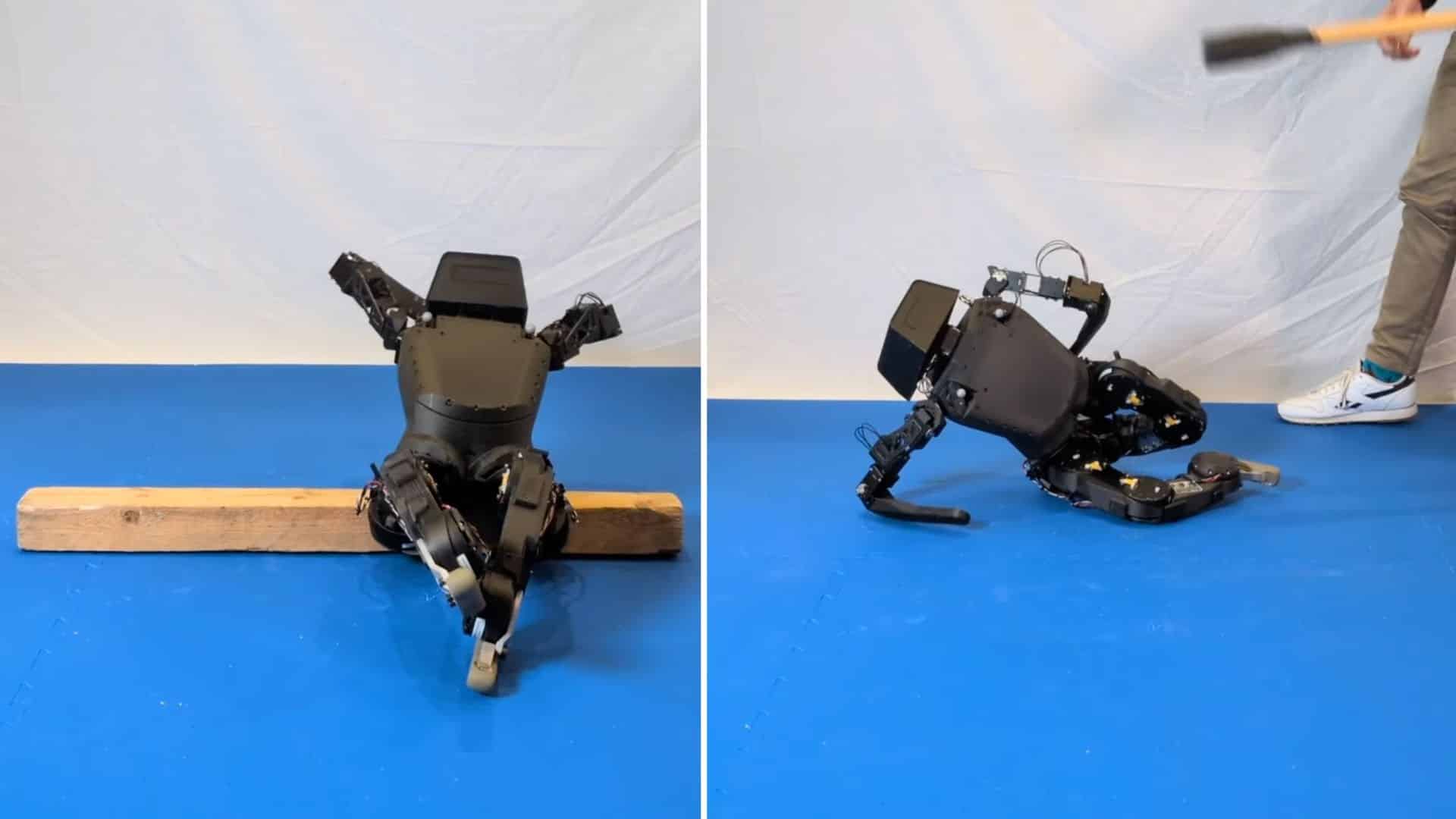

Prima di parlare di come un robot Disney risolverebbe il problema, vale la pena ricordare cosa succede quando nessuno lo risolve. Mosca, 11 novembre 2025. Palco, luci, tema di Rocky in sottofondo (la qual cosa ha reso tutto un po’ più ridicolo, diciamolo). Entra AIDOL, primo robot umanoide russo con intelligenza artificiale. Alza il braccio destro per salutare. “Nunn’a’ visto o’ rarillo2,” diremmo a Napoli per scherzare. Il resto è storia: AIDOL perde l’equilibrio. AIDOL cade faccia a terra. Gli assistenti corrono con un telo nero per coprirlo alla vista di giornalisti e ospiti. Siparietto alla Buster Keaton e sottile soddisfazione per noi umani nel vedere che questi babau della tecnologia, destinati secondo la vulgata a sostituirci, camminano ancora come se avessero una forte diarrea e si spetasciano spesso e volentieri al suolo.

Secondo l’amministratore delegato Vladimir Vitukhin, si è trattato di un errore di calibrazione nei sensori di equilibrio. Un “incidente utile”, l’ha chiamato con ironia. Utile o meno, il video è diventato virale in tre ore e ha dimostrato una cosa molto semplice: la caduta è il momento più critico nella vita di un robot bipede. Non conta quanto è sofisticato il tuo sistema di controllo se non hai un piano B per quando la gravità vince.

Il sistema Disney non impedisce a un robot cadute come quella di AIDOL. Le gestisce. La differenza è che un robot Disney addestrato con questo metodo non finisce faccia a terra con le articolazioni bloccate. Si ripiega, protegge la testa, sceglie una posa finale che distribuisce l’impatto, come una specie di stuntman. E poi si rialza.

Robot Disney, 24.000 cadute virtuali per imparare a soffrire meno

Il cuore del sistema, l’ho detto, è il reinforcement learning: migliaia di robot digitali che cadono dentro un simulatore, studiano cosa funziona e cosa no, accumulano dati. Ogni caduta genera punti se il robot riduce l’impatto o protegge zone critiche. Toglie punti se i movimenti diventano caotici o fuori controllo. Il sistema ha testato 24.000 pose stabili, lanciando modelli virtuali da varie altezze (sempre coerenti, non da dieci piani). Dieci delle pose finali sono arrivate da “artisti” che hanno creato posizioni creative: accovacciamenti, rotolamenti larghi, atterraggi drammatici.

Il training è durato due giorni su GPU potenti. 4.000 robot virtuali cadevano simultaneamente. Una piccola rete neurale processava angoli delle articolazioni, orientamento del corpo e dati di movimento cinquanta volte al secondo. Il metodo si chiama proximal policy optimization e adatta il comportamento del robot passo dopo passo senza salti improvvisi. Il simulatore ha ridotto la pressione di contatto e impostato livelli di sensibilità diversi per ogni parte del corpo: le gambe rimangono morbide, la testa richiede più protezione.

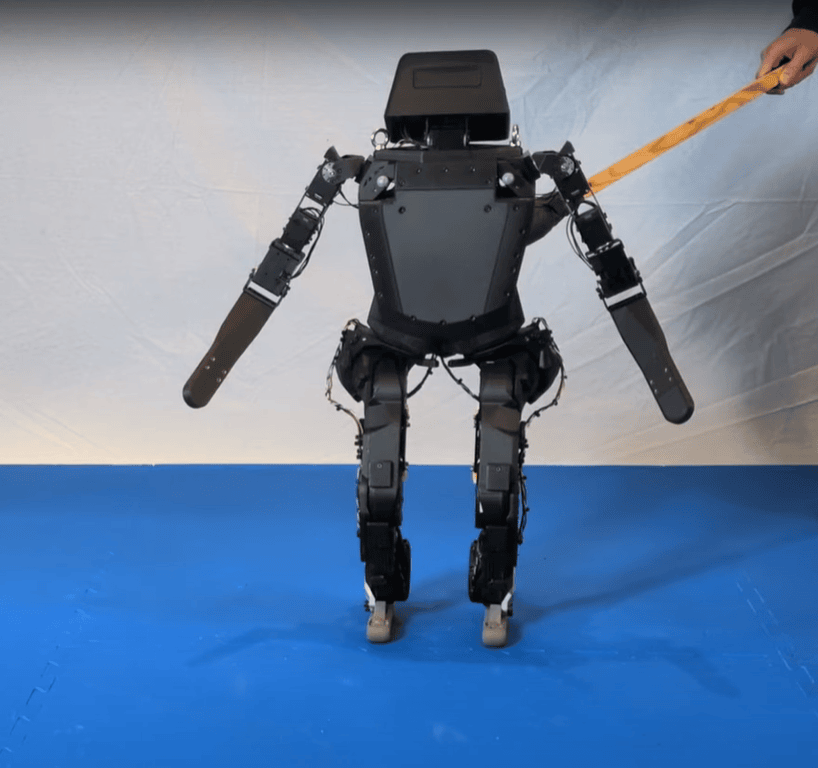

Dal simulatore al laboratorio: test sul robot Disney vero

Dopo il training virtuale, il sistema è stato installato in un robot Disney reale. Peso: 16 chilogrammi. Gambe a molla, braccia meccaniche. Un sistema di motion capture tracciava ogni movimento e inviava aggiornamenti al controller in tempo reale. I test hanno mostrato che il robot gestisce cadute da spinte laterali a 2 metri al secondo (circa 6,5 piedi al secondo) e scivolate in avanti con anche rotanti. Le velocità erano randomizzate in ogni episodio, quindi il robot non ha mai imparato un percorso fisso.

Il robot non resiste all’impatto: lo accoglie. Rotola, si posiziona, protegge batterie e sensori. La posa finale dipende dalla direzione della caduta e dalla velocità. A volte si accovaccia stretto. A volte si apre largo. A volte sceglie qualcosa a metà strada. Come raccontavo in questo articolo, la robotica del 2025 si muove verso sistemi più adattivi e intelligenti. Questo studio lo conferma: i robot non devono solo camminare bene. Devono anche (soprattutto, verrebbe da dire) cadere bene.

Il dato più interessante? Il sistema funziona con robot diversi. La policy è agnostica rispetto all’hardware: può essere trasferita su altre piattaforme bipedi senza riaddestrare tutto da zero. Questo significa che il metodo non è legato a un singolo modello, ma si applica a qualsiasi macchina con due gambe e articolazioni compatibili.

Perché insegnare a cadere conta più di quanto pensiamo

La questione di fondo è semplice. I robot bipedi stanno diventando più comuni. Qualcuno li ha messi già in prevendita. Fabbriche, magazzini, ospedali. Camminano tra noi, trasportano oggetti, eseguono compiti. Ma finché cadere significa rompersi, il loro utilizzo rimane limitato. Un robot che sa cadere senza danneggiarsi è un robot che può lavorare più a lungo, in più ambienti, con meno supervisione umana. Non è una questione di eleganza: è economia pura.

Disney Research ha scelto un approccio pragmatico. Non vende la caduta come spettacolo. La tratta come problema ingegneristico con una soluzione misurabile. Il robot cade, protegge le parti critiche, si rialza, continua. Niente teli neri, niente tema di Rocky, niente imbarazzo. Solo fisica applicata e reinforcement learning che funziona.

Basta un poco di learning e il robot va giù, se mi passate il gioco di parole cringe da papà di una ottenne. L’importante, ovviamente, è che si rialzi tutto intero.

- Il reinforcement learning è una tecnica di intelligenza artificiale in cui un agente impara a prendere decisioni interagendo con un ambiente, ricevendo ricompense per le azioni giuste e penalità per quelle sbagliate. Così, come avviene nel nostro apprendimento quotidiano per tentativi ed errori, l’agente migliora il proprio comportamento per raggiungere obiettivi nel tempo. È usato per insegnare alle macchine a risolvere problemi complessi dove devono fare una serie di scelte per ottenere il miglior risultato possibile. ↩︎

- “Non ha visto il gradino”. Si dice, talvolta, anche quando non c’è nessun gradino cui fare attenzione, solo per sottolineare in modo pietoso una improvvida caduta. Seguitemi per altre lezioni non richieste di Napoletano nelle note a piè pagina. ↩︎