Secondo l’ultimo report delle Nazioni Unite sulla guerra civile libica, l’anno che sta finendo ha visto per la prima volta un sistema d’arma autonomo, un robot killer, uccidere qualcuno. In futuro potremmo ricordarcelo come il punto di partenza di una nuova corsa agli armamenti che potrebbe farci male, molto male.

Nei giorni scorsi (dal 13 al 17 dicembre) La Convenzione dell’ONU su certe armi convenzionali si è riunita sul tema, come capita ogni cinque anni. Dal 1983 ad oggi questa assemblea ha scelto di limitare alcune armi crudeli come le mine antiuomo. Stavolta ha discusso di un possibile divieto di queste armi autonome. E non ha raggiunto un consenso per limitarle.

Potrebbe essere stato un errore catastrofico.

I sistemi d’arma autonomi sono robot killer. In tutto questo post mi sentirete sempre chiamarli così: robot killer. Perchè questo sono. Sistemi con armi che possono funzionare da sole. Sistemi fatti per la guerra, per uccidere le persone. I governi mondiali stanno investendo pesantemente in questo trend.

Dall’altro lato, ovviamente, le organizzazioni umanitare (una fra tutte, Stop The Killer Robots, che trovate qui) si spendono per chiedere regole e divieti sullo sviluppo di queste armi. E fanno bene. Se non limiteremo l’uso delle armi autonome, finirà molto male. Le tecnologie dirompenti in questo campo potranno destabilizzare tutte le strategie militari, aumentando il rischio di attacchi preventivi. Compresi quelli chimici, biologici, nucleari.

Dato il ritmo di sviluppo dei robot killer, l’incontro dell’ONU appena terminato potrebbe essere stata una delle ultime occasioni per evitare una nuova corsa agli armamenti. Oppure l’ultima.

Ci sono quattro pericoli che appaiono evidenti a chiunque, quando si parla di sistemi robotici killer.

Primo problema dei robot killer: identificazione.

le armi autonome saranno SEMPRE in grado di distinguere tra un soldato ostile e un bambino con una pistola giocattolo? La differenza tra un singolo errore umano (che pure è possibile) e l’errata impostazione di un algoritmo potrebbe portare il problema su una scala incredibile. Un esperto di armi autonome chiamato Paul Scharre usa una metafora: quella di un mitra difettoso che continua a sparare anche quando si toglie il dito dal grilletto. E spara finchè non finisce le munizioni, perchè semplicemente è una macchina. Non sa che sta commettendo un errore.

Checchè se ne dica, l’intelligenza artificiale non è ancora provvista di una sua morale (e probabilmente non ce l’avrà mai, non potrà apprenderla mai).

Il problema non è solo che anche una AI sbaglia, ad esempio quando riconosce l’asma come fattore che riduce il rischio di polmonite, o quando identifica le persone di colore come gorilla. È che quando sbaglia, chi l’ha creata non sa perchè ha sbagliato, e non sa come correggerla. Per questo ritengo impossibile che dei robot killer possano svilupparsi con un criterio “morale” di qualche genere.

Secondo problema dei robot killer: proliferazione di fascia bassa.

Le forze armate che stanno sviluppando armi autonome partono dal presupposto che saranno in grado di contenerle e controllarle. Avete sentito un’idea più stupida di questa? Se c’è una cosa che la storia della tecnologia delle armi ci insegna, una sola cosa, è che le armi si diffondono. Anche in questo caso era prevedibilissimo.

Quanto accaduto in passato con il Kalashinkov, un fucile d’assalto divenuto così accessibile da finire nelle mani di chiunque, può ripetersi per i robot killer. Le pressioni del mercato possono portare alla creazione di armi autonome efficaci, economiche e virtualmente impossibili da fermare. Più di tutto: diffuse. In mano a governi, cavalli pazzi, criminalità organizzata o gruppi terroristici.

Potrebbe essere già accaduto. Il Kargu-2, realizzato da un appaltatore della difesa turco, è un incrocio tra un drone e una bomba. Ha un’intelligenza artificiale per trovare e tracciare obiettivi. È un robot killer, e ha già agito autonomamente nel teatro della guerra civile libica per attaccare le persone.

Terzo problema dei robot killer: proliferazione di fascia alta.

Se pensiamo poi ai rischi “di fascia alta” arriviamo allo Zenit. Le nazioni potrebbero competere per sviluppare versioni sempre più devastanti di armi autonome, comprese quelle in grado di montare armi chimiche, biologiche, radiologiche e nucleari . I pericoli morali dell’escalation della letalità delle armi sarebbero amplificati dall’escalation dell’uso delle armi.

Certo, è probabile che questi robot killer saranno dotati di costosi controller etici progettati per ridurre al minimo i danni collaterali, inseguendo il mito dell’attacco “chirurgico”. Una roba buona solo per l’opinione pubblica, insomma. La verità è che le armi autonome altereranno anche la più banale analisi dei costi e dei benefici che si fa prima di pianificare una guerra. Saranno dadi di un Risiko mortale, da lanciare con meno preoccupazione.

Le guerre asimmetriche condotte sul suolo di nazioni prive di tecnologie concorrenti, diventeranno più comuni. Una instabilità enormemente diffusa.

Quarto e ultimo problema: le leggi di guerra

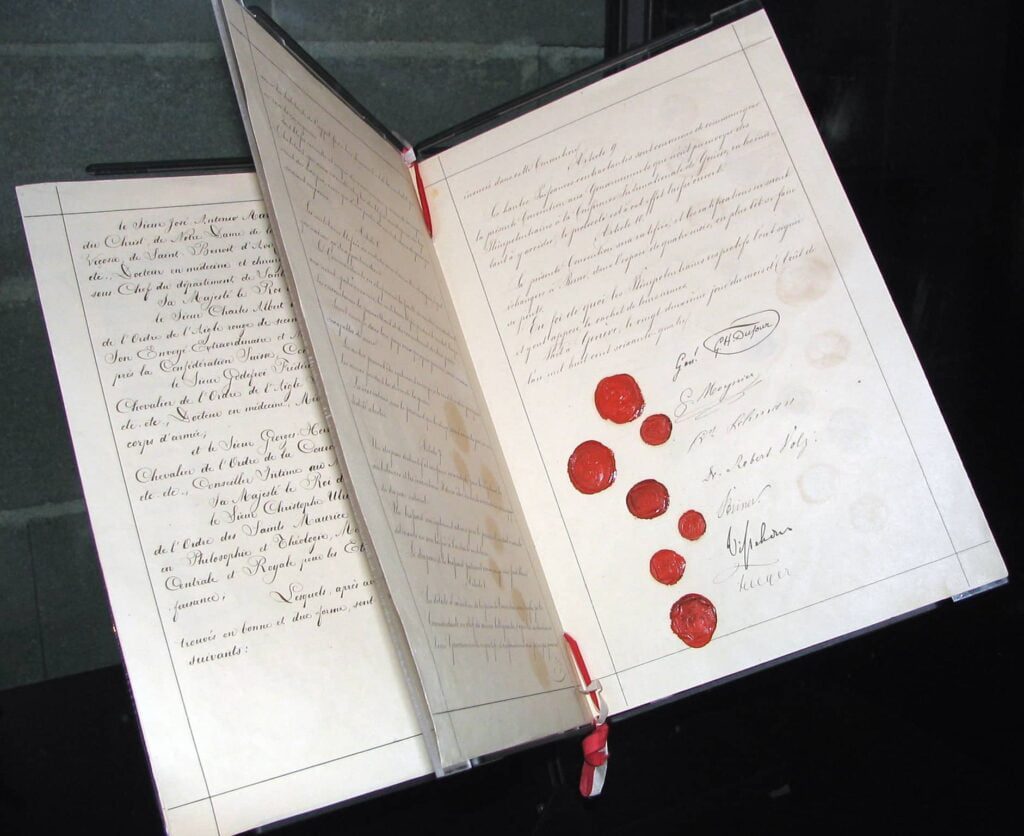

I robot killer (se prolifereranno è una cosa certa) mineranno l’ultimo palliativo dell’umanità contro i crimini e le atrocità di guerra: le leggi internazionali di guerra. Queste leggi, codificate in trattati che partono dalla prima Convenzione di Ginevra, sono la sottile linea che separa la guerra da qualcosa ancora peggiore che faccio fatica ad immaginare.

Le leggi di guerra sono fondamentali, perchè impongono responsabilità anche a chi sta combattendo una guerra. Slobodan Milosevic era il presidente di un paese e doveva rispondere delle sue azioni. È stato processato nel Tribunale Penale Internazionale delle Nazioni Unite per l’ex Jugoslavia e ha dovuto rispondere di ciò che ha fatto.

E ora? Di è la colpa di un robot killer che commette crimini di guerra? Chi viene processato? L’arma? Il soldato? I comandanti del soldato? La società che ha fabbricato l’arma? Le ONG e gli esperti di diritto internazionale temono che le armi autonome portino a un grave divario di responsabilità .

Si dovrà dimostrare che un soldato ha commesso un crimine utilizzando un’arma autonoma. Per fare questo, si dovrà dimostrare che il soldato ha commesso un atto colpevole e aveva anche la precisa intenzione di farlo. Una dinamica piuttosto complicata, in un mondo di robot killer.

Un mondo di robot killer è un mondo senza regole che impongono un controllo umano significativo sulle armi. È un mondo dove verranno commessi crimini di guerra senza criminali di guerra da ritenere responsabili. La struttura delle leggi di guerra, insieme al loro valore deterrente, sarà notevolmente indebolita.

Una nuova corsa globale agli armamenti

Immaginate che ognuno possa usare tutta la forza che vuole, quando vuole. Con meno conseguenze per nessuno. Immaginate un pianeta nel quale militari, gruppi di insorti e terroristi nazionali e internazionali possono schierare una forza letale teoricamente illimitata a rischio teoricamente zero in tempi e luoghi di loro scelta, senza alcuna responsabilità legale risultante.