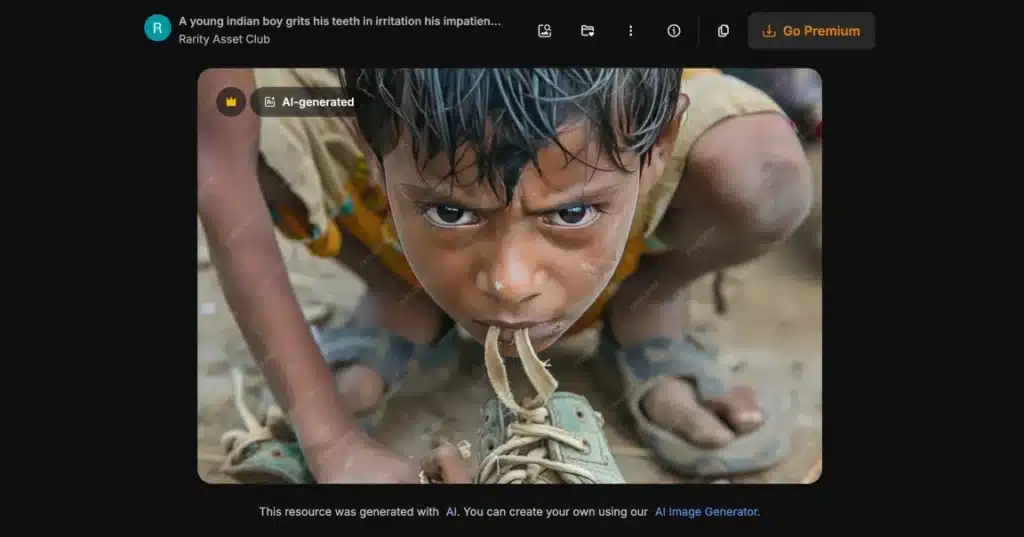

I bambini affamati generati dall’intelligenza artificiale hanno un vantaggio rispetto a quelli veri: non servono consensi, non costano biglietti aerei, non pongono problemi etici. Almeno secondo le organizzazioni che li stanno usando per le campagne di beneficenza. Arsenii Alenichev ha raccolto oltre 100 di queste immagini sintetiche pubblicate su LinkedIn, X e nei materiali promozionali di ONG internazionali. Bambini scheletrici con ciotole vuote, rifugiati africani, volontari bianchi salvatori. La grammatica visiva è identica a quella del “poverty porn” che le stesse organizzazioni avevano giurato di abbandonare. Solo che ora tutto è falso, prodotto in proprio con un’AI o comprato su servizi di marketplace… di immagini AI. E va benissimo così, giusto? O no?

Quando la povertà diventa un prodotto da scaffale

Alenichev, ricercatore presso l’Istituto di Medicina Tropicale di Anversa, ha pubblicato su The Lancet Global Health uno studio che documenta un fenomeno inquietante. Tra gennaio e luglio 2025 ha raccolto più di 100 immagini AI utilizzate da individui e piccole organizzazioni, spesso con sede in paesi a basso e medio reddito. Le immagini replicano l’intensità emotiva e la grammatica visiva del “poverty porn” tradizionale: bambini emaciati con ciotole vuote, macerie, scene stereotipate che riducono intere popolazioni a corpi sofferenti.

Ma non sono solo realtà minori. Plan International, organizzazione britannica, ha usato video con immagini AI di ragazze adolescenti incinte e abusate in una campagna contro i matrimoni precoci. Il video ha ottenuto oltre 300.000 visualizzazioni. L’Organizzazione Mondiale della Sanità ha pubblicato nel 2023 una campagna anti-tabacco con l’immagine di un bambino africano sofferente, completamente generata dall’intelligenza artificiale. Persino le Nazioni Unite, secondo quanto riportato da The Guardian, avrebbero utilizzato “ricostruzioni” AI di violenze sessuali.

“È piuttosto chiaro che varie organizzazioni stanno iniziando a considerare immagini sintetiche invece della fotografia reale, perché costa poco e non devi preoccuparti del consenso e di tutto il resto”, ha dichiarato Alenichev a The Guardian. Anche in questo caso le immagini replicano la grammatica visiva della povertà.

Beneficenza “on demand”: il supermercato degli stereotipi

Una ricerca rapida su Freepik o Adobe Stock restituisce decine, forse centinaia, di immagini AI etichettate come “bambino surreale in campo profughi”, “bambini asiatici che nuotano in un fiume pieno di spazzatura”, “volontario bianco che fornisce assistenza medica a bambini neri in un villaggio africano”. Quest’ultima, venduta su Adobe Stock, costa circa 60 sterline. Secondo PetaPixel, in tre anni sono state caricate 300 milioni di immagini AI su Adobe Stock, lo stesso quantitativo che ai fotografi veri ha richiesto vent’anni di tempo.

Joaquín Abela, CEO di Freepik, ha scaricato ogni responsabilità sugli utenti. La piattaforma, ha spiegato, ospita contenuti creati da una comunità globale che può ricevere royalty quando i clienti acquistano le loro foto. Una posizione che ignora completamente il problema: queste immagini sono palesemente razziste e perpetuano i peggiori stereotipi su Africa, India e altri paesi. Alenichev le definisce senza giri di parole: “Queste foto sono palesemente razziste e non dovrebbero poter essere pubblicate perché rappresentano i peggiori stereotipi”.

Poverty porn 2.0

Il termine “poverty porn” è nato nel 2007 per descrivere immagini voyeuristiche di persone povere o oppresse, progettate per scioccare gli spettatori nei paesi sviluppati e spingerli a donare. L’idea era semplice: mostrare sofferenza estrema per alimentare la fantasia che una donazione potesse risolvere il problema. Dopo anni di critiche, molte ONG avevano adottato linee guida etiche per evitare questo tipo di comunicazione.

Ora l’intelligenza artificiale ha riportato indietro l’orologio. Alenichev chiama il fenomeno “poverty porn 2.0”: i soggetti delle immagini sono diventati anch’essi fantasia, evitando persino i costi finanziari ed etici della documentazione della sofferenza reale. Non serve più un fotografo sul campo, non servono permessi, non serve confrontarsi con persone vere. Basta un prompt ben scritto e pochi secondi di elaborazione.

Il problema non riguarda solo la beneficenza tradizionale. Come documentato da Fanpage, su Facebook circolano decine di immagini AI di bambini malati di cancro usate per il “like farming”: post che chiedono auguri, like e condivisioni per “aiutare” bambini inesistenti. Una volta raggiunto un certo engagement, le pagine vengono rivendute o utilizzate per diffondere truffe e disinformazione.

L’AI addestrata sui nostri pregiudizi

Il problema va oltre l’uso opportunistico delle immagini sintetiche. Come abbiamo raccontato su Futuro Prossimo, i modelli di intelligenza artificiale vengono addestrati su miliardi di immagini del nostro passato e presente, assorbendo tutti i nostri bias e pregiudizi. Il risultato? Quando chiedi a Midjourney di generare “dottori africani che curano bambini bianchi sofferenti”, il sistema produce quasi sempre bambini neri. In 22 casi su 350, i dottori risultavano bianchi nonostante le istruzioni esplicite.

Malik Afegbua, filmmaker nigeriano, ha provato a generare immagini di anziani africani eleganti sulle passerelle. “Quello che ottenevo erano persone dall’aspetto stracciato e segnato dalla povertà”, ha raccontato. L’AI riproduce meccanicamente gli stereotipi visivi che abbiamo accumulato in decenni di comunicazione coloniale.

Beneficenza AI: una questione di fiducia

Kate Kardol, consulente di comunicazione per ONG, ha dichiarato a The Guardian: “Mi rattrista che la lotta per una rappresentazione più etica delle persone che vivono in povertà si estenda ora anche all’irreale”. Un portavoce di Plan International ha precisato che l’organizzazione “attualmente sconsiglia l’uso dell’AI per rappresentare i bambini”.

Il punto è che siamo già in ritardo. Le immagini sintetiche circolano, vengono condivise, usate per addestrare la prossima generazione di modelli AI. E questo significa che il problema si autoalimenta: più immagini stereotipate produciamo, più l’intelligenza artificiale imparerà a replicarle. Alenichev e i suoi colleghi propongono trasparenza: dichiarare l’uso dell’AI e rendere pubblici i prompt utilizzati. Ma servirà qualcosa di più. Servirà mettere in discussione l’idea che la sofferenza sia un prodotto da comprare su uno stock fotografico.

E capire che i bambini affamati, se proprio devono essere esibiti nelle nostre campagne, dovrebbero almeno esistere davvero.