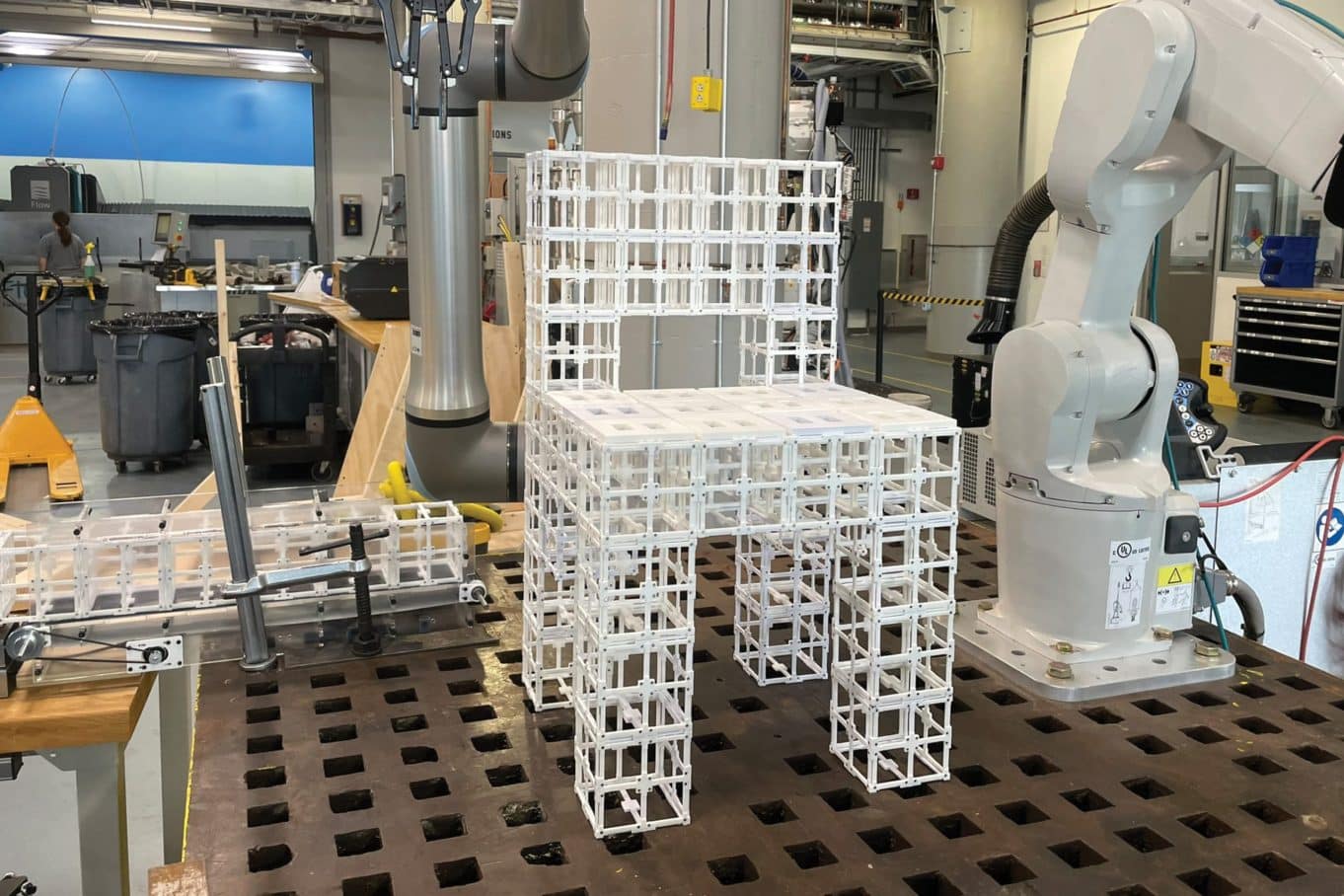

Cambridge, Massachusetts, laboratorio MIT CSAIL. Il dottorando Alex Kyaw digita “make me a chair” su un prompt. Lo schermo mostra un prospetto 3D generato dall’intelligenza artificiale. Un secondo modello osserva il prospetto e decide: pannelli sullo schienale e seduta, struttura portante nelle gambe. Il braccio robotico inizia a muoversi, e assembla dei componenti prefabbricati: otto minuti dopo, c’è una sedia. Nessun disegno tecnico, nessun file CAD aperto: solo parole e un robot che le ha capite. Il design AI non è più teoria: è assemblaggio fisico.

Due modelli, un oggetto

Il sistema usa design AI a doppio strato. Il primo modello generativo costruisce la rappresentazione 3D dall’input testuale. Riceve “sedia”, restituisce una mesh completa con superfici, volumi, angoli. Fin qui, niente di nuovo: i modelli generativi fanno questo da tempo.

Il problema è che producono geometrie uniformi, belle da vedere ma inutili per l’assemblaggio robotico. Mancano i dettagli sui componenti, sui punti di giunzione, sulle funzioni specifiche di ogni parte.

Qui entra il secondo modello: un vision-language model (VLM) addestrato a vedere immagini e comprendere testo. Guarda la mesh 3D come se fosse una foto e ragiona sulla funzione dell’oggetto. Dove serve appoggio? Dove serve struttura? Il VLM identifica le superfici che necessitano di pannelli (seduta, schienale) e quelle che rimangono strutturali (gambe, traversi).

Non applica regole meccaniche: capisce. Ha visto abbastanza sedie, tavoli, scaffali durante l’addestramento da riconoscere pattern funzionali. “La seduta ha bisogno di una superficie perché qualcuno ci si siede sopra.” È ovvio, per noi. Meno ovvio per una macchina.

Umano nel loop

L’utente resta dentro al processo. Il design AI propone una configurazione iniziale: pannelli su seduta e schienale, struttura nuda sulle gambe. Se non piace, come in un qualsiasi dialogo con un modello di linguaggio, l’utente può modificare il prompt: “solo pannelli sullo schienale, non sulla seduta”.

Il sistema ricalcola, il robot riassembla. È co-design iterativo: l’AI suggerisce, l’umano sceglie, il robot esegue. Lo spazio delle possibilità è enorme, troppo per esplorarlo tutto. Il feedback dell’utente restringe il campo, definisce preferenze, guida il risultato finale.

Richa Gupta, altra dottoranda MIT in architettura e coautrice dello studio, sottolinea che il processo umano-nel-loop permette agli utenti di guidare i design AI generati e avere un senso di proprietà sul risultato finale. Non è automazione cieca: è collaborazione.

Scheda dello Studio

- Ente di ricerca: MIT – Computer Science and Artificial Intelligence Laboratory (CSAIL), Dipartimenti EECS e Architecture

- Ricercatori principali: Alex Kyaw (lead author), Richa Gupta, Faez Ahmed, Lawrence Sass, Randall Davis (senior author)

- Collaboratori: Google DeepMind, Autodesk Research

- Anno pubblicazione: 2024

- Conferenza: Neural Information Processing Systems (NeurIPS)

- Paper: Text to Robotic Assembly of Multi Component Objects using 3D Generative AI and Vision Language Models

- TRL (Technology Readiness Level): 6 – Dimostrazione in ambiente rilevante (prototipi funzionanti, test utente completati)

Design AI e componenti riutilizzabili

Il sistema usa due tipi di componenti prefabbricati: strutturali e pannelli. Strutturali per portanza, pannelli per superfici. Tutti riutilizzabili. Finito di usare la sedia? La disassembli, riusi i pezzi per uno scaffale. Il design AI gestisce questa modularità: sa quali componenti servono per quale funzione, ottimizza l’assemblaggio, riduce gli sprechi. Come un LEGO guidato dall’intelligenza artificiale, e per oggetti a grandezza naturale.

I ricercatori hanno testato il sistema contro due algoritmi di controllo: uno che posiziona pannelli su tutte le superfici orizzontali rivolte verso l’alto, uno che li posiziona casualmente. Poi ha sottoposto i prodotti al giudizio del pubblico.

Risultato: oltre il 90% ha preferito i design AI generati dal sistema MIT. Non è solo efficienza: è comprensione funzionale. Il VLM ha imparato a distinguere “questa superficie serve per sedersi” da “questa è solo struttura”.

Oltre i mobili

Al momento il sistema assembla sedie, scaffali, tavolini. Componenti semplici, geometrie controllate. Ma le applicazioni potenziali vanno oltre l’arredamento domestico. Prototipazione rapida di componenti aerospaziali, strutture architettoniche modulari, oggetti personalizzati prodotti on-demand senza necessità di spedizione da fabbriche centralizzate.

Randall Davis, professore EECS e senior author dello studio, parla di abbassare drasticamente la barriera d’accesso agli strumenti di design AI:

“Abbiamo dimostrato che possiamo usare AI generativa e robotica per trasformare idee in oggetti fisici in modo veloce, accessibile e sostenibile.”

Il team prevede già i prossimi passi: gestire prompt più complessi (“fammi un tavolo in vetro e metallo”), integrare componenti mobili come ingranaggi e cerniere, espandere la varietà di materiali utilizzabili. Il design AI è ancora limitato a rappresentazioni discrete e modulari, ma la direzione è chiara.

Approfondisci

Ti interessa il futuro della robotica? Leggi anche L’ascesa dei robot umanoidi: sostituiranno davvero il lavoro umano? per capire come l’automazione sta ridefinendo le mansioni industriali. Oppure scopri Mobile ALOHA, il robot maggiordomo di Google che impara per imitazione. Per applicazioni spaziali, esplora come i robot costruiscono infrastrutture spaziali in ambienti estremi.

Otto minuti dal prompt vocale all’oggetto finito: il CAD non c’entra più niente. Questo è quello che resta del processo: un prompt, due modelli AI, un braccio robotico, componenti modulari.

Il design AI ha appena dimostrato che la complessità tecnica può essere nascosta dietro un’interfaccia che parla linguaggio umano. Resta da capire se l’industria seguirà. I segnali ci sono: investimenti da Google DeepMind e Autodesk Research non arrivano per caso. Il mercato della prototipazione rapida vale miliardi, e chi arriva prima con un sistema stabile conquista lo standard.

Anzi, lo costruisce.